ollama使用huggingface拉取模型第二个文件出现异常

现象:

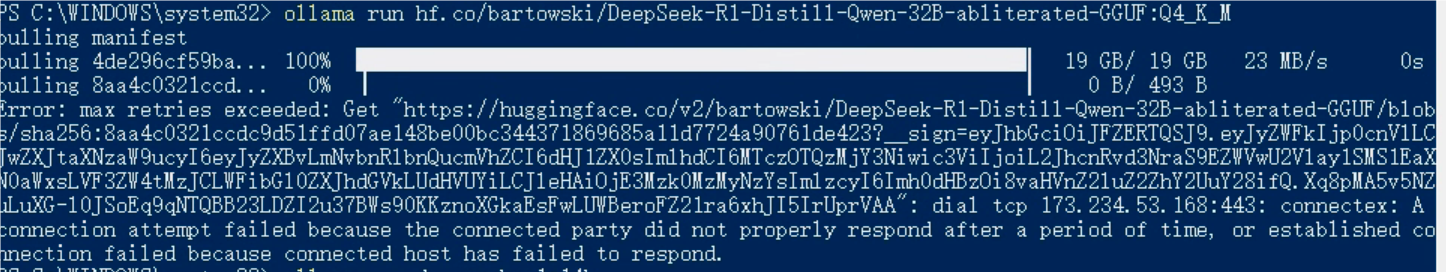

拉取huggingface的deepseek r1的去限制模型时,除了模型本体,其它都拉取失败

Error: max retries exceeded: Get "https://huggingface.co/v2/bartowski/deepseek-r1-qwen-2.5-32B-ablated-GGUF/blobs/sha256:8aa4c0321ccdc9d51ffd07ae148be00bc344371869685a11d7724a90761de423?__sign=eyJhbGciOiJFZERTQSJ9.eyJyZS1xd2VuLTIuNS0zMkItYWJsYXRlZC1HR1VGIiwiZXhwIjoxNzM5NDMzMTMyLCJpc3MiOiJodHRwczovL2h1Z2dpbmdmYWNlLmNvIn0.KJNqPtIpIc7n83_LzbLiDl9xw2N6cuS9Vf2rPsMlUqISYKf-dMq71QJtfAtkXd6EXgqddPsiQ-xipEfbY_RVCQ": dial tcp [2a03:2880:f127:283:face:b00c:0:25de]:443: connectex: A connection attempt failed because the connected party did not properly respond after a period of time, or established connection failed because connected host has failed to respond.问题原因:

第一个是模型文件,走的cdn,国内有加速。后面三个都是描述文件,需要科学环境。

尝试使用设置 http_proxy与https_proxy,ollama仍然不走代理。如果没有一个完整的科学环境,可以使用hf-mirror.com

解决方式:

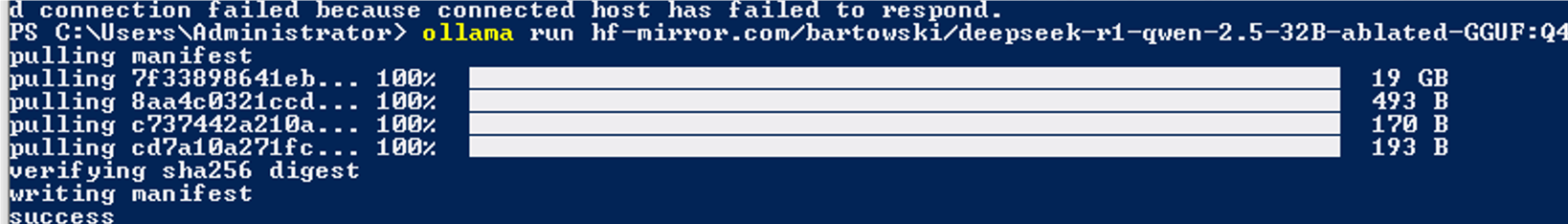

替换成镜像地址hf-mirror.com

tips:第一个模型文件拉取完后不要关闭ollama!!!否则缓存就没了,又要重新拉!

在出现异常后,关闭所有代理,直接将你的

ollama run hf.co/{username}/{reponame}:latest

//or

ollama run huggingface.co/{username}/{reponame}:latest

//替换成

ollama run hf-mirror.com/{username}/{reponame}:latest